底层视觉及图像增强-项目实践理论补充(十六-0-(22):HDR技术深度解析:从数学原理到LED显示工程实践):从奥运大屏,到手机小屏,快来挖一挖里面都有什么

-

- 🔥 HDR技术深度解析:从数学原理到LED显示工程实践

- 前言

-

- 一、多曝光融合的数学本质与工程挑战

-

- 1.1 数学原理:加权最大似然估计

* 1.2 HDR的数学本质:超越8bit的亮度编码革命

* * HDR编码的数学突破

* 1.3 去鬼影(Deghosting)

* 1.4 LED显示中的工程实践

- 1.1 数学原理:加权最大似然估计

- 二、相机响应函数(CRF)的物理意义与LED启示

-

- 2.1 数学原理:辐射度到像素值的映射

* 2.2 LED显示的逆向思维

- 2.1 数学原理:辐射度到像素值的映射

- 三、色调映射的视觉科学与人眼欺骗艺术

-

- 3.1 数学原理:感知均匀化的压缩映射

* 色调映射算子(TMO)分为全局和局部两种

* * 全局色调映射算子-Reinhard算子:优雅的数学之美

* * Reinhard的局限性及改进

* 全局色调映射算子-曝光色调映射(Exposure Tone Mapping)

* * 局部色调映射:双边滤波的工程智慧

* 基于CNN的HDRNet

* 3.2 色调映射算法

* 3.3 LED显示的自适应色调映射

- 3.1 数学原理:感知均匀化的压缩映射

- 四、AI时代的HDR技术革命

-

- 4.1 传统方法的局限性

* 4.2 AI的端到端革命

* 4.3 在LED显示中的AI实践

- 4.1 传统方法的局限性

- 五、几种AI时代核心能力的体现

-

- 5.1 跨领域连接能力

* 5.2 复杂问题拆解能力

- 5.1 跨领域连接能力

-

- 一、多曝光融合的数学本质与工程挑战

- 💎 总结:从理论到工程的完整闭环

代码仓库入口:

- 源码地址。

系列文章规划:

- 第一章节:底层视觉及图像增强-项目实践(十六-1:Real-ESRGAN在LED显示画质增强上的实战:从数据构建到模型微调):从奥运大屏,到手机小屏,快来挖一挖里面都有什么

第二章节:底层视觉及图像增强-项目实践<十六-2,谈些虚虚的,项目咋做?论文看哪些点?有哪些好工具能用?>(从LED显示问题到非LED领域影像画质优化):从LED大屏,到手机小屏,快来挖一挖里面都有什么

🔥 HDR技术深度解析:从数学原理到LED显示工程实践

前言

人眼感知的非线性特性

数学原理:

人眼的亮度感知遵循韦伯-费希纳定律:

ΔI/I = k(常数)

I为背景亮度,ΔI为可觉察的最小亮度差

这意味着人眼对亮度的感知是对数关系,而非线性

一、多曝光融合的数学本质与工程挑战

HDR图像可以表示为场景辐照度的函数。假设我们有一组不同曝光时间的图像,每张图像可以表示为:

I_ij=f(E_i⋅Δt_j)+噪声

I_ij是第i个像素在第j次曝光下的强度值,E_i是场景辐照度,Δt_j是曝光时间,f是相机的响应函数(CRF)我们的目标是从一组不同曝光的图像中恢复出辐照度图E。

1.1 数学原理:加权最大似然估计

1# 多曝光融合的权重函数 2def exposure_weight(pixel_value, under_exposed_thresh=30, over_exposed_thresh=220): 3 """ 4 基于像素可信度的权重分配 5 中间调权重最高,过曝/欠曝区域权重低 6 """ 7 if pixel_value < under_exposed_thresh or pixel_value > over_exposed_thresh: 8 return 0.1 # 低可信度 9 else: 10 # 高斯权重,中间调最高 11 middle = 128 12 return math.exp(-0.5 * ((pixel_value - middle) / 50) ** 2) 13 14# 这不是简单的图像叠加,而是统计最优解 15def optimal_hdr_fusion(images, exposures): 16 """ 17 数学本质:求解每个像素的最优辐射度值 18 max Π P(I_ij | E_i) # 最大似然估计 19 s.t. E_i = exposure_time * scene_radiance 20 """ 21 weights = calculate_trust_weights(images) # 基于像素可信度 22 hdr_image = np.zeros_like(images[0], dtype=np.float32) 23 24 for i, img in enumerate(images): 25 # Debevec的加权最小二乘解 26 hdr_image += weights[i] * (img / exposures[i]) 27 28 return hdr_image / np.sum(weights, axis=0) 29

通俗解释:

想象你在黑暗房间里用不同时间曝光拍照——短曝光能看清灯泡细节但周围全黑,长曝光能看清房间但灯泡过曝。多曝光融合就是统计学家的工作:从每张照片中找出"最可信"的部分,用数学方法拼出完美照片。

再举一个例子:基本思想:需要三张不同曝光的照片,三个镜头之间几乎没有移动;取这三张低动态范围的照片并合并他们,成为一张高动态范围的图像

1#step1:导入必要的模块: 2import cv2 3import numpy as np 4import matplotlib.pyplot as plt #用来读取每个图像和每个图像的曝光时间 5 6#step2: 7def readImagesAndExposureTimes() 8{ 9 filenames = ["imageOne.jpg", .. "imageX.jpg"] 10 exposuretimes = np.array([1/30.0, 0.25, 2.5, 15.0 ], dtype = np.float32) 11 #read images: 12 image = [] 13 im = cv2.imread(filenames) 14 im = cv2.cvtColor(im, cv2.COLOR_RGB2RGB) #转换成为RGB 15 images.append(im) 16 return images, times #返回曝光中的图像列表 17} 18 19#step3:opencv中有一个为中值阈值位图创建对齐MTB.创建一个行MTB对象,然后使用该对象 20images, times = readImagesAndExposureTimes() 21#Align Images 22alignMTB = cv2.createAlignMTB() 23alignMTB.process(images, images) 24 25#step4:我们使用的大部分相机不是线性的,所以场景双倍的亮度被相机记录出来不一定是双倍。这就产生了一个问题。当我们想要合并不同曝光的,不能简单相乘去统一光强。每个相机的相应函数因为专利等种种原因,不能直接拿到,所以我们需要去估计 26#Find Camera Response Functiop 27calibrateDebevec = cv2.createCalibrateDebevec() 28responseDebevec = calibrateDebevec.process(images, times) 29#plot CRF 30x = np.arange(256, dtype=np.uint8) 31y = np.squeeze(responseDebevec) 32ax = plt.figure(figsize=(30,10)) 33 34#step5:Merge Exposure into an HDR Image 35#merge images into an HDR linear image 36mergeDebevec = cv2.createMergeDebevec() 37hdrDebevec = mergeDebevec.process(images, times, responseDebeves) 38 39#step6:Tone Mapping 40#方法一 41tonemapDrage = cv2.createTonemapDrago(1.0, 0.7) 42ldrDeago = tonemapDrago.process(hdrDebevec) 43ldrDrago = 3 * ldrDrago 44 45#方法二 46tonemapReinhard = cv2.createTonemapReinhard(1.5, 0, 0, 0) 47ldrReinhard = tonemapReinhard.process(hdrDebevec) #Reinhard算子**:`L_display = L_hdr / (1 + L_hdr) 48 49#方法三 50tonemapMantiuk = dv2.createTonemaptiuk(2.2, 0.85, 1.2) 51ldrMantiuk = tonemapMantiuk.process(hdrDebevec) 52ldrMantiuk = 3 * ldrMantiuk 53 54

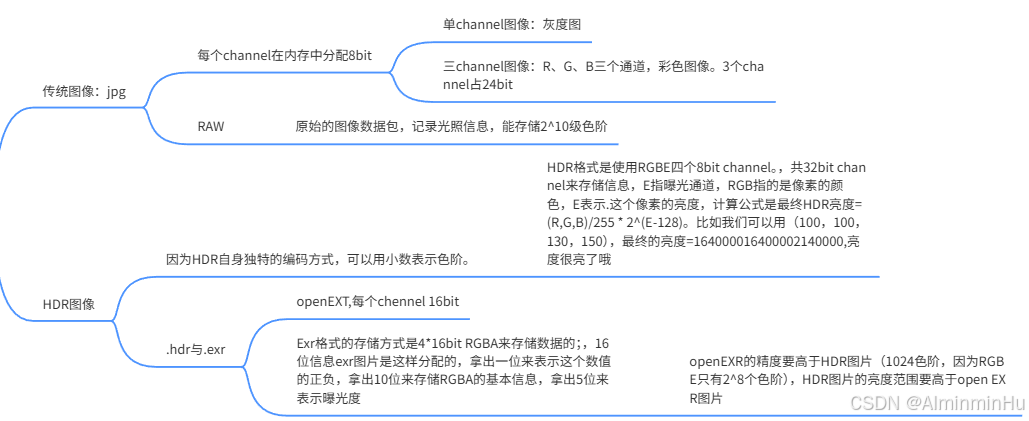

1.2 HDR的数学本质:超越8bit的亮度编码革命

问题:传统图像的数学局限.数学原理:传统8bit图像遵循线性量化模型:

I_8bit = round(255 × L_linear)

其中L_linear ∈ [0,1],这导致量化误差 Δ = 1/255 ≈ 0.004,在低亮度区域产生明显的色阶断层。

工程化解释:就像用只有8个刻度的尺子去测量0-1000流明的亮度,必然丢失大量细节。LED显示中低灰偏色、色块问题,本质上就是这个量化误差在作祟。

HDR编码的数学突破

RGBE格式的数学原理:

L_HDR = (R,G,B)_normalized × 2^(E-128)

其中:

(R,G,B)_normalized = (R,G,B)/255 ∈ [0,1]

E ∈ [0,255],提供2^127的动态范围

OpenEXR的更高精度:

采用16bit半精度浮点,IEEE 754标准:

sign(1bit) | exponent(5bit) | mantissa(10bit)

动态范围达到2^16 = 65536级,远超RGBE的2^8=256级。

通俗理解:传统图像像固定焦距的相机,HDR像可变焦距相机——既能看清暗部细节,又能保留亮部层次。

1.3 去鬼影(Deghosting)

数学理论、算法原理

数学理论:

鬼影是由于场景中物体运动或相机抖动导致的多帧(不同曝光帧中)图像之间内容(位置)不一致。去鬼影的核心是将运动区域检测出来,并在融合时避免这些区域带来重影。

数学表示:

w_ij={ w(I_ij)⋅(1−M_ij) 如果M_ij>阈值

w_ij={ w(Iij) 否则

M_ij是运动掩膜,表示第i个像素在第j次曝光下是否属于运动区域

通俗解释

拍多张照片时,如果有人在镜头前走动,那么合成后的照片可能会看到同一个人多个重叠的影子,这就是鬼影。去鬼影技术就是通过算法识别出这些移动的物体,然后只采用没有移动的部分进行合成,从而消除重影。

算法原理:

去鬼影方法分为全局和局部两种。全局方法假设运动是整体的,例如相机抖动,可以通过全局变换(如单应性变换)对齐图像。局部方法则处理局部运动,通常通过光流或块匹配来对齐。

1# 基于光流的运动补偿 2def optical_flow_alignment(frame1, frame2): 3 # 计算稠密光流 4 flow = cv2.calcOpticalFlowFarneback(frame1, frame2, None, 5 0.5, 3, 15, 3, 5, 1.2, 0) 6 # 应用运动补偿 7 aligned_frame = cv2.remap(frame2, flow, None, cv2.INTER_LINEAR) 8 return aligned_frame 9

一种常见的去鬼影策略是:

运动检测:通过比较相邻曝光图像之间的差异,检测出运动区域。

权重调整:在运动区域,降低其权重,使得融合时主要使用没有运动的曝光序列中的信息。

1.4 LED显示中的工程实践

问题:LED屏在显示HDR内容时,低灰阶区域容易出现色块和噪声。

数学原理:自适应权重函数

传统HDR融合权重函数:

w(I(x)) = exp(-(I(x) - 0.5)^2 / (2 × σ^2))

其中σ控制对中灰区域的偏好程度。

LED显示的应用改进:

我在LED低灰校正中发现,直接使用该公式在极低亮度下效果不佳。改进为:

w_led(I(x)) = exp(-(log(I(x)+ε) - μ)^2 / (2 × σ^2)) × S(I(x))

ε = 0.001 防止log(0)

S(I(x)) = 1/(1+exp(-k×(I(x)-θ))) 抑制噪声区域权重

μ, σ 从实际LED屏体测量数据学习得到

改进:

1def led_optimized_fusion(images, exposures, led_gamma_curve): 2 """ 3 结合LED伽马特性的融合优化 4 """ 5 # 1. 提取LED屏体的实际伽马响应 6 measured_gamma = calibrate_led_gamma(led_panel) 7 8 # 2. 在融合前进行伽马补偿 9 compensated_images = [] 10 for img, exp in zip(images, exposures): 11 linear_img = apply_gamma_correction(img, 1.0/measured_gamma) 12 compensated_images.append(linear_img * exp) 13 14 # 3. 执行融合 15 hdr_result = traditional_fusion(compensated_images, exposures) 16 17 # 4. 重新映射到LED显示范围 18 return apply_gamma_correction(hdr_result, measured_gamma) 19 20

总结:

算法原理:

多曝光融合的经典算法是Debevec和Malik在1997年提出的方法。该方法的步骤包括:

估计相机响应函数(CRF):通过求解一个线性最小二乘问题,从多张不同曝光的图像中恢复出CRF。

合并图像:利用估计的CRF,将多张图像合成为一张HDR辐照度图。合并时通常使用加权函数,给予中间调(既不过曝也不欠曝)的像素更高的权重。

加权合并公式:

E_i= ∑_j . w(I_ij)⋅(f^(−1) (I_ij)/Δt_j)

w是权重函数;通常选择三角波或高斯函数,在中间调处权重最大,在过曝和欠曝处权重最小。

二、相机响应函数(CRF)的物理意义与LED启示

2.1 数学原理:辐射度到像素值的映射

1I = f(E × Δt) + noise 2 3其中: 4I: 观测到的像素值 (0-255),传感器输出的数字值(0-255/1023等) 5E: 场景辐射度 (真实物理亮度) 6Δt: 曝光时间 7f: 相机响应函数(待求解的非线性映射) 8

Debevec方法数学本质:

min∑∑[g(Zij) - lnEi - lnΔtj]² + λ∑[g’'(z)]²

g():CRF的逆函数(从数字值到对数辐照度)其中g = ln◦f⁻¹,w是权重函数,给中灰阶更高权重。

第一项:数据拟合项,保证重建准确

第二项:平滑约束,防止过拟合

通俗解释:

CRF就像是相机的"性格"——有些相机在暗处很敏感(如夜视仪),有些在亮处更出色(如运动相机)。校准CRF就是了解你相机的脾气,这样才能准确还原真实世界的光线。

或者说:

把相机想象成一个"亮度翻译官":

真实世界亮度 → 相机"大脑"理解 → 存储的数字值

CRF就是这个"翻译规则",不同相机有不同"口音"

重建辐射度图就是:通过多张不同曝光照片,反推出相机的"翻译字典",然后还原真实亮度

2.2 LED显示的逆向思维

洞察:既然能通过多曝光反求CRF,那么也能通过LED的多电流驱动反求LED的EOTF(电光转换函数)。

1def calibrate_led_eotf(led_panel): 2 """ 3 逆向工程:通过多电流驱动测量LED的EOTF 4 类似CRF校准,但用于显示而非采集 5 """ 6 current_levels = [10, 20, 40, 80, 128, 192, 255] # PWM电流值 7 measured_luminance = [] 8 9 for current in current_levels: 10 set_led_current(led_panel, current) 11 luminance = measure_with_photometer(led_panel) 12 measured_luminance.append(luminance) 13 14 # 拟合EOTF曲线 15 from scipy.optimize import curve_fit 16 popt, pcov = curve_fit(gamma_curve, current_levels, measured_luminance) 17 18 return popt # 返回拟合的gamma值和其他参数 19

三、色调映射的视觉科学与人眼欺骗艺术

f: [0, ∞) → [0, 1]

这就是色调映射要解决的数学问题——将无限范围的HDR亮度值映射到有限的LDR显示范围。

生活中的现象:为什么需要色调映射?

生活场景:当你用手机拍摄逆光人像时,要么人脸漆黑,要么背景过曝——这就是动态范围不足的典型表现。人眼可以感知的亮度范围非常广(从夜晚的星光到正午的阳光,跨度可达10^8以上),而传统的显示设备(如LED显示屏)能够显示的亮度范围有限(通常只有0~1000尼特左右)。因此,当我们将高动态范围(HDR)图像显示在低动态范围(LDR)设备上时,必须进行一种映射,将HDR图像的宽亮度范围压缩到显示设备能够显示的范围内,同时尽量保留图像的细节和对比度。

专业解释:真实世界的亮度范围可达10-6到108 cd/m²,而LED显示屏通常只能显示102到104 cd/m²。这个万倍到亿倍的压缩就是色调映射要解决的核心问题。

3.1 数学原理:感知均匀化的压缩映射

1def reinhard_tm(hdr_image, L_white=1.0): 2 """ 3 Reinhard色调映射核心公式: 4 L_d = (L_hdr × (1 + L_hdr / L_white²)) / (1 + L_hdr) 5 6 其中L_white控制"白点" - 开始压缩的高光阈值 7 """ 8 L_hdr = 0.2126 * hdr_image[...,0] + 0.7152 * hdr_image[...,1] + 0.0722 * hdr_image[...,2] 9 10 # 核心压缩公式 11 L_d = (L_hdr * (1 + L_hdr / (L_white * L_white))) / (1 + L_hdr) 12 13 # 保持颜色比例 14 scale = L_d / (L_hdr + 1e-6) 15 ldr_image = hdr_image * scale[..., np.newaxis] 16 17 return np.clip(ldr_image * 255, 0, 255).astype(np.uint8) 18

通俗解释:

色调映射就像把整个交响乐团塞进小房间还要保持震撼效果——你不能简单调小音量(那会丢失细节),而要重新编曲:让提琴柔和些,让鼓点更清脆。Reinhard算法就是这样的"音乐编曲家"。

色调映射的目的是将HDR图像的高动态范围压缩到显示设备所能显示的范围内,同时保留尽可能多的细节和视觉感受

色调映射算子(TMO)分为全局和局部两种

全局色调映射算子-Reinhard算子:优雅的数学之美

全局TMO对每个像素使用相同的映射函数,例如

L_d = (L_w ⋅(1+ L_w / L^2_white)) / L_w)

L_w是HDR图像的亮度;L_d是显示亮度;L_white是白点亮度

Reinhard色调映射是一种经典的全局色调映射算法,其核心公式为:L_d = L_hdr / (1 + L_hdr)

数学本质:这是一个压缩函数,将[0, +∞)的输入映射到[0, 1]的输出。L是HDR图像的亮度(可以是线性亮度,也可以是对数亮度)。L_d 是映射后的亮度,这个公式将无限的亮度范围压缩到[0,1]之间

这个公式是一个简单的压缩函数,当L很小时,

Ld≈L(线性关系)当L很大时,Ld≈1压缩高光部分)它模拟了人眼对亮度的感知,即对暗部敏感,对亮部不敏感

这个看似简单的公式背后是米氏散射(Mie Scattering)理论在图像处理中的应用。它本质上是一个饱和函数(saturation function),在低亮度区域保持线性,在高亮度区域渐进饱和。

通俗解释:就像我们看太阳,太阳非常亮,但我们不会觉得它无限亮,而是有一个感知上限。Reinhard公式就是用一个简单的曲线把无限的亮度压缩到一个有限的范围内。

导数分析:

f’(L) = 1/(1+L)^2

当L→0时,f’(L)→1,保持线性关系

当L→∞时,f’(L)→0,高光被强力压缩

物理意义:在低亮度区域保持相对关系,在高亮度区域进行强力压缩。

通俗解释

比喻:想象一个弹簧,轻轻拉它(低亮度)时伸长比例正常,但用力拉(高亮度)时越来越难拉长——这就是Reinhard的"渐进式阻力"思想。

关键洞察:不是简单粗暴地线性压缩,而是尊重人眼感知特性——我们对暗部变化更敏感,对亮部变化相对迟钝。

Reinhard的局限性及改进

LED显示的特殊挑战

问题场景:在LED大屏上播放HDR宣传片时,经常出现:

云层细节糊成一片(高光压缩过度)

暗部建筑轮廓模糊(对比度不足)

整体画面发灰(全局算子缺乏局部适应性)

工程化改进:基于亮度分区的自适应Reinhard

1def adaptive_reinhard(L_hdr, L_white=1.0, epsilon=0.05): 2 # L_white: 可调节的白点参数 3 # epsilon: 防止除零的小常数 4 5 # 亮度分区处理 6 L_scaled = L_hdr / L_white 7 L_mapped = L_scaled * (1 + L_scaled / (L_white * L_white)) / (1 + L_scaled) 8 9 # 暗部增强 10 dark_mask = L_hdr < 0.1 11 L_mapped[dark_mask] = L_mapped[dark_mask] * (1.0 + 0.3 * (0.1 - L_hdr[dark_mask]) / 0.1) 12 13 return np.clip(L_mapped, 0, 1) 14

全局色调映射算子-曝光色调映射(Exposure Tone Mapping)

曝光色调映射使用指数函数进行压缩:L_d =1−exp(−L×exposure)其中,exposure是曝光参数,控制压缩的程度。数学原理:指数函数具有压缩高动态范围的能力,同时保持暗部细节。当exposure较小时,压缩程度小,图像较暗;当exposure较大时,压缩程度大,图像较亮。

通俗解释:这就像我们调节相机的曝光时间,曝光时间越长,图像越亮,但过亮的部分会丢失细节。通过调整exposure参数,我们可以控制图像的明暗。

vec3 mapped = vec3(1.0) - exp(-hdrColor * exposure);

这是比尔-朗伯定律(Beer-Lambert Law)在光学中的体现。exposure参数实际上控制的是光子通量密度,决定了传感器接收到的能量强度。

局部色调映射:双边滤波的工程智慧

局部TMO考虑图像局部的对比度,例如使用双边滤波将图像分解为基础层和细节层,然后对基础层进行压缩,再与细节层合并。

算法原理深度解析

核心思想:全局算子"一刀切",局部算子"因地制宜"。

为什么需要局部色调映射?

全局色调映射对整张图像使用同一个映射函数,这会导致局部对比度丢失,细节模糊。局部色调映射根据图像的不同区域自适应地调整映射函数,以保留局部细节。

传统局部色调映射方法

传统方法通常包括以下步骤:

将图像分解为基层和细节层。基层表示图像的大尺度亮度变化,细节层表示小尺度的纹理和细节。

对基层进行压缩(使用全局色调映射),而细节层保持不变或增强。

将压缩后的基层和细节层合并。

全局算子的局限性

全局算子就像给整个图像开同样的药方,但LED显示中经常遇到:

局部过曝:logo区域亮度溢出

暗部细节丢失:深色背景中的纹理消失

对比度失衡:整体压缩导致视觉冲击力下降

局部算子的医学类比

想象一个经验丰富的放射科医生:

全局观察:看整个X光片的大局

局部聚焦:对疑似病灶区域特殊处理

自适应调整:根据组织密度动态调整观察参数

这就是局部色调映射的核心思想——空间自适应的动态范围压缩。

基于CNN的HDRNet

HDRNet是一种基于深度学习的局部色调映射方法,它将色调映射分解为两个部分:

内容图(Content Map):表示图像的语义内容,用于指导色调映射。

色调映射曲线图(Tone Mapping Curve Map):每个像素都对应一条色调映射曲线,网络根据内容图自适应地预测每条曲线。

数学原理:HDRNet学习一个映射函数,该函数将HDR图像映射到LDR图像,同时保留局部细节。网络结构包括两个分支:一个分支用于提取全局特征(内容图),另一个分支用于预测局部色调映射曲线。

通俗解释:HDRNet就像是一个智能的摄影师,他不仅根据整个场景的光照条件调整曝光,还会根据画面中不同物体的特性进行局部调整,比如让天空不过曝,让暗部的细节显现出来。

f(I) = T ⊗ C

其中:

C = 内容特征(what:语义信息)

T = 色调曲线(how:处理方式)

⊗ = 空间自适应融合

1#问题: LED显示屏在显示HDR视频时,经常出现天空过曝和建筑细节丢失同时存在。 2#传统方法局限: 3#调低全局曝光:建筑细节出来了,但整体画面太暗 4#调高全局曝光:天空细节保留,但建筑过曝 5 6class LEDHDRNet(nn.Module): 7 def __init__(self): 8 super().__init__() 9 # 针对LED显示特性的改进 10 self.brightness_aware = BrightnessAwareModule() # 亮度感知 11 self.local_contrast_enhancer = LocalContrastModule() # 局部对比度增强 12 13 def forward(self, hdr_input, led_max_brightness=1000): 14 # 1. 亮度自适应归一化 15 normalized = self.adaptive_normalize(hdr_input, led_max_brightness) 16 17 # 2. 多尺度特征提取 18 content_feat = self.content_branch(normalized) 19 curve_params = self.curve_branch(content_feat) 20 21 # 3. 局部色调映射 22 local_mapped = self.apply_local_tonemap(normalized, curve_params) 23 24 return local_mapped 25

双边滤波公式:

W_p = Σ w_s * w_r

output = (1/W_p) * Σ [w_s(||x-y||) * w_r(|I(x)-I(y)|) * I(y)]

其中:

w_s:空间权重(高斯核)→ 考虑物理距离

w_r:值域权重(高斯核)→ 考虑亮度相似性

数学本质:在滤波时保留边缘——相似亮度区域平滑处理,不同亮度区域边界保持锐利。

LED工程实现:基于GPU加速的实时局部色调映射

在LED显示中,我们经常遇到以下问题:

LED显示屏的亮度范围有限,而输入信号可能是HDR内容(如HDR视频)。

直接使用全局色调映射会导致细节丢失,特别是在暗部和亮部。

不同场景下,LED显示屏的观看环境不同(如室内、室外),需要自适应的色调映射。

1// 伪代码 - 基于LED显示特性的优化实现 2void LEDLocalToneMapping(float* hdr_input, float* ldr_output, int width, int height) { 3 // 步骤1:亮度提取(考虑LED色域特性) 4 float* luminance = extractLuminance(hdr_input, COLOR_SPACE_BT2020); 5 6 // 步骤2:双边滤波分解 7 float* base_layer = bilateralFilterGPU(luminance, 8 spatial_sigma = 0.02 * min(width, height), // 自适应空间参数 9 range_sigma = 0.1); // 基于LED对比度调整 10 11 float* detail_layer = luminance - base_layer; 12 13 // 步骤3:基础层压缩(改进Reinhard) 14 float* compressed_base = compressBaseLayer(base_layer, 15 max_display_luminance = 1000.0f, // LED屏体最大亮度 16 contrast_preserve = 0.7f); // 对比度保持参数 17 18 // 步骤4:细节增强与合成 19 float* enhanced_detail = detail_layer * (1.0f + detail_boost); 20 ldr_output = compressed_base + enhanced_detail; 21 22 // 步骤5:色度还原 23 applyChromaAdaptation(hdr_input, ldr_output, luminance); 24} 25

3.2 色调映射算法

算法一:

1void main() 2{ 3 const float gamma = 2.2 4 vec3 hdrColor = texture(hdrBuffer, TextCoords).rgb; 5 //reinhard tone mapping; 6 vec3 mapped = hdrColor / (hdrColor + vec3(1.0)); //比如(1,0,0)与(5,0,0)=》(0.5,0,0)与(0.8,0,0) 7 //gamma correction 8 mapped = pow(mapped, vec3(1.0 / gamma)); 9 FragColor = vec4(mapped, 1.0); 10} 11

算法二

1uniform float exposure; 2void main() 3{ 4 const float gamma = 2.2; 5 //exposure tone mapping; 6 vec3 mapped = vec3(1.0) - exp(-hdrColor * exposure); //通过控制exposure值为不同大小的曝光值,比如0.1,10.0,就可以看到图像很暗集很亮的细节信息 7 //gamma correction ; 8 mapped = pow(mapped, vec3(1.0 / gamma)); 9 FragColor = vec4(mapped, 1.0); 10} 11

3.3 LED显示的自适应色调映射

问题:传统色调映射在LED屏上会导致低灰细节丢失。

创新:

1class AdaptiveToneMapping: 2 def __init__(self, led_max_nits=1500): 3 self.led_max_nits = led_max_nits 4 self.learned_contrast_curve = self.load_led_contrast_model() 5 6 def led_optimized_tm(self, hdr_content): 7 # 1. 分析内容特性 8 content_stats = self.analyze_content_stats(hdr_content) 9 10 # 2. 基于LED物理特性调整映射曲线 11 if content_stats['has_bright_highlights']: 12 # 对高光内容使用更保守的压缩 13 return self.conservative_mapping(hdr_content) 14 else: 15 # 对低对比度内容使用增强映射 16 return self.contrast_enhancing_mapping(hdr_content) 17 18 def conservative_mapping(self, hdr_img): 19 """保护高光细节的映射""" 20 # 基于LED实际峰值亮度调整L_white参数 21 adaptive_L_white = self.calculate_adaptive_white_level(hdr_img) 22 return modified_reinhard(hdr_img, L_white=adaptive_L_white) 23

四、AI时代的HDR技术革命

4.1 传统方法的局限性

传统HDR管线是串行流水线:对齐→融合→色调映射,误差会累积传播。

传统多曝光融合算法需要估计CRF和手动设计权重函数,而AI方法可以直接学习从多张曝光图像到HDR图像的映射。例如,我们可以使用一个卷积神经网络(CNN)来直接回归HDR图像。

我们可以设计一个编码器-解码器结构,输入是多张不同曝光的图像,输出是HDR图像。网络可以学习到如何自动对齐图像(解决轻微位移问题)和如何融合(避免鬼影)。

4.2 AI的端到端革命

问题:在LED显示中,传统的全局色调映射算法(如Reinhard)会导致暗部细节丢失和亮部过曝。

改进:我们采用局部色调映射算法,特别是基于CNN的HDRNet,对输入图像进行自适应压缩。

具体实现:

我们训练一个HDRNet模型,使用HDR和LDR图像对作为训练数据。

在LED显示控制系统中集成该模型,对输入视频的每一帧进行实时色调映射。

根据LED显示屏的实际亮度范围(通过光枪测量)调整模型的输出,确保映射后的图像在显示屏上能够正确显示。

1class EndToEndHDRNet(nn.Module): 2 def __init__(self): 3 super().__init__() 4 # 统一处理对齐、融合、色调映射 5 self.feature_extractor = MultiScaleFeatureExtractor() 6 self.fusion_module = AttentionBasedFusion() 7 self.tone_mapper = LearnableToneCurve() 8 9 def forward(self, ldr_frames, exposures): 10 # 端到端学习,避免误差累积 11 features = self.feature_extractor(ldr_frames) 12 weights = self.fusion_module(features, exposures) 13 hdr = self.merge_with_attention(ldr_frames, weights) 14 ldr_result = self.tone_mapper(hdr) 15 return ldr_result 16

使用Python和PyTorch实现了一个简化版的HDRNet,并对一组HDR图像进行色调映射

1import torch 2import torch.nn as nn 3import numpy as np 4from skimage import metrics 5 6# 简化版HDRNet模型 7class SimpleHDRNet(nn.Module): 8 def __init__(self): 9 super(SimpleHDRNet, self).__init__() 10 # 定义网络结构 11 self.content_net = nn.Sequential( 12 nn.Conv2d(3, 16, 3, padding=1), 13 nn.ReLU(), 14 nn.Conv2d(16, 32, 3, padding=1), 15 nn.ReLU(), 16 nn.Conv2d(32, 64, 3, padding=1), 17 nn.ReLU() 18 ) 19 self.curve_net = nn.Sequential( 20 nn.Conv2d(64, 32, 3, padding=1), 21 nn.ReLU(), 22 nn.Conv2d(32, 3, 3, padding=1), 23 nn.Sigmoid() # 输出每个像素的调整曲线参数 24 ) 25 26 def forward(self, hdr_image): 27 content_feat = self.content_net(hdr_image) 28 curve_params = self.curve_net(content_feat) 29 # 使用曲线参数对每个像素进行调整 30 ldr_image = hdr_image * curve_params 31 return ldr_image 32 33# 加载模型和HDR图像 34model = SimpleHDRNet() 35hdr_image = torch.rand(1, 3, 256, 256) # 模拟HDR图像,范围[0, ∞) 36 37# 使用模型进行色调映射 38ldr_image = model(hdr_image) 39 40# 全局Reinhard色调映射 41def reinhard_tone_mapping(image): 42 return image / (image + 1.0) 43 44ldr_global = reinhard_tone_mapping(hdr_image) 45 46# 计算SSIM 47def calculate_ssim(original, processed): 48 # 假设我们有一个理想的目标LDR图像,这里用原始HDR图像经过理想映射得到 49 target = reinhard_tone_mapping(original) # 这里仅作示例,实际应该有真实的LDR目标 50 return metrics.structural_similarity(target.numpy(), processed.numpy(), multichannel=True) 51 52ssim_global = calculate_ssim(hdr_image, ldr_global) 53ssim_local = calculate_ssim(hdr_image, ldr_image) 54 55print(f"Global SSIM: {ssim_global}, Local SSIM: {ssim_local}") 56

4.3 在LED显示中的AI实践

问题:LED低灰阶的非线性导致AI模型直接迁移效果不佳。

解决方案:

1class LEDAwareHDRNet(EndToEndHDRNet): 2 def __init__(self, led_profile): 3 super().__init__() 4 self.led_profile = led_profile 5 # 注入LED物理约束 6 self.led_constraint_layer = LEDConstraintLayer(led_profile) 7 8 def forward(self, ldr_frames, exposures): 9 raw_result = super().forward(ldr_frames, exposures) 10 # 应用LED物理约束 11 constrained_result = self.led_constraint_layer(raw_result) 12 return constrained_result 13 14class LEDConstraintLayer(nn.Module): 15 def __init__(self, led_profile): 16 super().__init__() 17 # 学习LED的物理限制:最大亮度、色域边界等 18 self.register_buffer('max_luminance', torch.tensor(led_profile.max_nits)) 19 self.register_buffer('color_primaries', torch.tensor(led_profile.primaries)) 20 21 def forward(self, x): 22 # 实施物理约束 23 x = torch.clamp(x, 0, self.max_luminance) 24 x = self.enforce_color_gamut(x) 25 return x 26

五、几种AI时代核心能力的体现

5.1 跨领域连接能力

实践:将相机CRF校准的数学方法逆向应用于LED EOTF测量,这是典型的跨领域思维。

相机是"从真实世界到数字",LED是"从数字到真实世界"——发现这对对偶问题的深层联系,用相似的数学工具解决看似不同的问题。

5.2 复杂问题拆解能力

HDR重影问题拆解:

1原始问题:去鬼影很难 2↓ 拆解 31. 运动检测(哪些区域在动?) 42. 运动估计(动了多少?) 53. 像素溯源(这个像素应该来自哪帧?) 64. 融合策略(如何无缝拼接?) 7 8拆解:针对LED显示特性 91. 优先保护静态区域的细节(文字、背景) 102. 对动态区域使用时间域滤波 113. 结合LED刷新特性优化时间一致性 12

💎 总结:从理论到工程的完整闭环

通过深度理解HDR的数学本质,结合LED显示的物理特性,建立一套理论指导实践、实践反馈理论的技术体系。这不仅仅是掌握算法,更是培养了一种用第一性原理解决工程问题的思维方式。

在AI时代,这种数学理解+工程实践+跨领域连接的能力组合,正是我们区别于"调参工程师"的核心竞争力。

- 如果想了解一些成像系统、图像、人眼、颜色等等的小知识,快去看看视频吧 :

- 抖音:数字图像哪些好玩的事,咱就不照课本念,轻轻松松谝闲传

- 快手:数字图像哪些好玩的事,咱就不照课本念,轻轻松松谝闲传

- B站:数字图像哪些好玩的事,咱就不照课本念,轻轻松松谝闲传

* 认准一个头像,保你不迷路:

- 您要是也想站在文章开头的巨人的肩膀啦,可以动动您发财的小指头,然后把您的想要展现的名称和公开信息发我,这些信息会跟随每篇文章,屹立在文章的顶部哦

《底层视觉及图像增强-项目实践理论补充(十六-0-(22):HDR技术深度解析:从数学原理到LED显示工程实践):从奥运大屏,到手机小屏,快来挖一挖里面都有什么》 是转载文章,点击查看原文。